Twój własny ChatGPT lokalnie – darmowy i bez limitów

Temat trochę mniej WordPressowy, ale związany z bezpieczeństwem. Często w moich wpisach poruszam tematy, związane z bezpieczeństwem WordPressa, więc jeśli korzystasz ze sztucznej inteligencji, powinieneś również starać się robić to bezpiecznie. I taki właśnie sposób pokażę Ci w tym artykule.

Dlaczego warto uruchomić ChatGPT lokalnie?

Praca z AI w chmurze zawsze wiąże się z ryzykiem. Dane dostępowe, fragmenty kodu czy klucze API przekazywane do modeli online mogą trafić poza naszą kontrolę. Dane mogą być używane do trenowania modeli itd. Uruchomienie ChatGPT na komputerze lokalnym eliminuje ten problem — wszystko pozostaje na dysku, a prywatność jest w pełni zachowana. (musisz tylko dbać o to, aby nikt nieuprawniony nie dostał się do Twojego komputera)

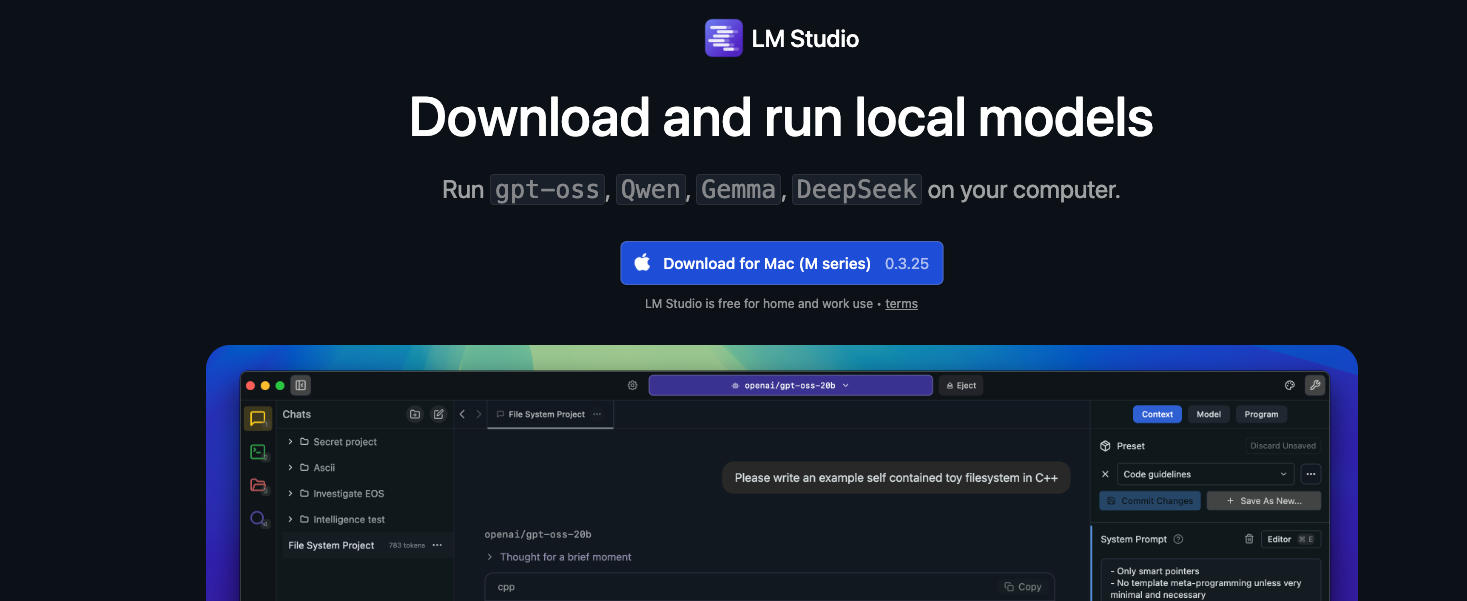

Narzędzie: LM Studio

Do uruchomienia własnej instancji ChatGPT wystarczy darmowa aplikacja LM Studio dostępna na Windows i macOS. Po instalacji wybieramy poziom użytkownika (od podstawowego po deweloperski), a następnie pobieramy model językowy.

Modele i wymagania sprzętowe

- ChatGPT 20B – ok. 21 mld parametrów, zajmuje ~12 GB, działa płynnie przy 16 GB RAM.

- ChatGPT 120B – 117 mld parametrów, wymaga nawet 120 GB RAM, przeznaczony dla mocnych stacji roboczych.

Ja przetestowałem wersję 20B i spokojnie ta wersja wystarcza do codziennych zadań. W narzędziu LM Studio możesz korzystać także z innych modeli językowych, które są na bieżąco aktualizowane.

Funkcje i możliwości

- Generowanie odpowiedzi w tempie ~58 tokenów/s.

- Obsługa plików (PHP, PDF, TXT, CSV) nawet do 30 MB.

- Możliwość instalacji dodatków, np. sandbox do testowania kodu JS.

- Pełna historia konwersacji zapisywana lokalnie — bez ryzyka wycieku.

Zastosowania lokalnego Chata GPT w praktyce

Model 20B radzi sobie m.in. z:

- tworzeniem prostych wtyczek i snippetów do WordPressa

- analizą kodu,

- pracą z plikami tekstowymi, plikami csv

Wg twórców, model gpt-oss-20b osiąga wyniki zbliżone do OpenAI o3‑mini w popularnych testach porównawczych i może działać na urządzeniach brzegowych z zaledwie 16 GB pamięci, dlatego idealnie nadaje się do zastosowań na urządzeniach, lokalnego wnioskowania lub szybkiej iteracji bez drogiej infrastruktury. Oba modele osiągają również bardzo dobre wyniki dotyczące użycia narzędzi, wywoływania funkcji typu few-shot, rozumowania z użyciem łańcucha myśli oraz w teście HealthBench (są one lepsze nawet od modeli własnościowych, takich jak OpenAI o1 i GPT‑4o).

Zaawansowane ustawienia

Domyślny limit promptu to 5000 tokenów, ale można go zwiększyć nawet do 130 000. Wymaga to jednak mocniejszej maszyny i odpowiedniego zarządzania pamięcią RAM. Po zmianie ustawień konieczne jest ponowne załadowanie modelu. Swoje testy przeprowadziłem na komputerze MacStudio M2 Max z 2023 r.

Podsumowanie

Lokalny ChatGPT przez LM Studio to realna alternatywa dla rozwiązań w chmurze. Daje pełną kontrolę nad danymi, szybkie działanie i dobrze radzi sobie z codziennymi zadaniami. Jeśli chcesz zobaczyć, jak to działa w praktyce, zobacz poniższy film, gdzie pokazuję krok po kroku jak zainstalować i zacząć używać ChataGPT za pomocą LM Studio na własnym komputerze.

Zabezpiecz stronę WordPress w kilka minut! Dwuetapowa weryfikacja logowania WordPress 6.9 – przegląd najważniejszych nowości i zmian